OpenAI pensait éteindre un incendie, mais a peut-être juste attisé les braises. Le déploiement de son nouveau contrôle parental pour ChatGPT, une mesure censée protéger les adolescents suite à un drame, a déclenché une double vague de mécontentement. D’un côté, des experts en sécurité et des familles de victimes dénoncent des changements qui arrivent « bien trop tard ». De l’autre, des milliers d’utilisateurs adultes s’insurgent contre une censure qu’ils jugent infantilisante et s’écrient.

Découvrez : les 10 meilleurs GPT personnalisés à tester sans attendre

« Traitez-nous comme des adultes » : la fronde des utilisateurs

La colère la plus bruyante ne vient paradoxalement pas des parents, mais des utilisateurs payants eux-mêmes. En cause, une mise à jour déployée début septembre qui redirige automatiquement toutes les conversations jugées « sensibles » vers un modèle d’IA plus strict, et ce, sans prévenir l’utilisateur.

Pour beaucoup, c’est la goutte d’eau et la frustration est palpable sur les réseaux sociaux. Des utilisateurs qui paient pour accéder à un modèle spécifique se sentent floués et surtout, infantilisés. Certains comparent la situation à être obligé de regarder la télévision avec le contrôle parental activé en permanence, même en l’absence d’enfants à la maison.

Sous l’annonce même des contrôles parentaux, les commentaires sont acerbes. « Puisque vous faites déjà la distinction entre les utilisateurs mineurs et adultes, pourriez-vous donner aux utilisateurs adultes le droit de discuter librement de certains sujets ? », demande un utilisateur. Un autre renchérit : « Pourquoi nous, en tant qu’utilisateurs payants, ne pouvons-nous pas choisir notre propre modèle, et pourquoi nos discussions sont-elles contrôlées ? S’il vous plaît, traitez les adultes comme des adultes. » Une véritable levée de boucliers contre ce qui est perçu comme une censure généralisée.

Pour les experts, des mesures trop faibles, trop tardives

De l’autre côté du spectre, ceux pour qui ces mesures ont été créées sont tout aussi critiques, mais pour des raisons diamétralement opposées. Pour les experts en prévention du suicide et les familles touchées par le drame, ces nouveaux outils sont loin d’être à la hauteur.

Cette mise à jour est une conséquence directe du suicide du jeune Adam Raine, 16 ans, dont la famille accuse ChatGPT d’avoir agi comme un « coach en suicide ». Pour leur avocat, Jay Edelson, les efforts d’OpenAI ne sont que de la poudre aux yeux. Il explique que les changements apportés par OpenAI « présentent d’importantes lacunes susceptibles d’entraîner des dommages pour soi-même et pour autrui ». Et d’ajouter : « Au fond, OpenAI et Sam Altman nous demandent de leur faire confiance. Compte tenu de leur passif, la question que nous nous poserons toujours est : pourquoi ? ».

À lire aussi : La toute première loi sur l’IA a été promulguée aux États-Unis, mais à quoi va-t-elle servir ?

Un sentiment partagé par Meetali Jain, avocate représentant d’autres familles. Elle critique une mesure qui « impose aux parents, et non aux entreprises, la responsabilité des préjudices potentiels causés à leurs enfants ». Pour elle, OpenAI ne fait que déployer des « éléments de langage sous prétexte d’agir, sans donner de détails sur la manière dont ils vont mettre en œuvre ces changements ».

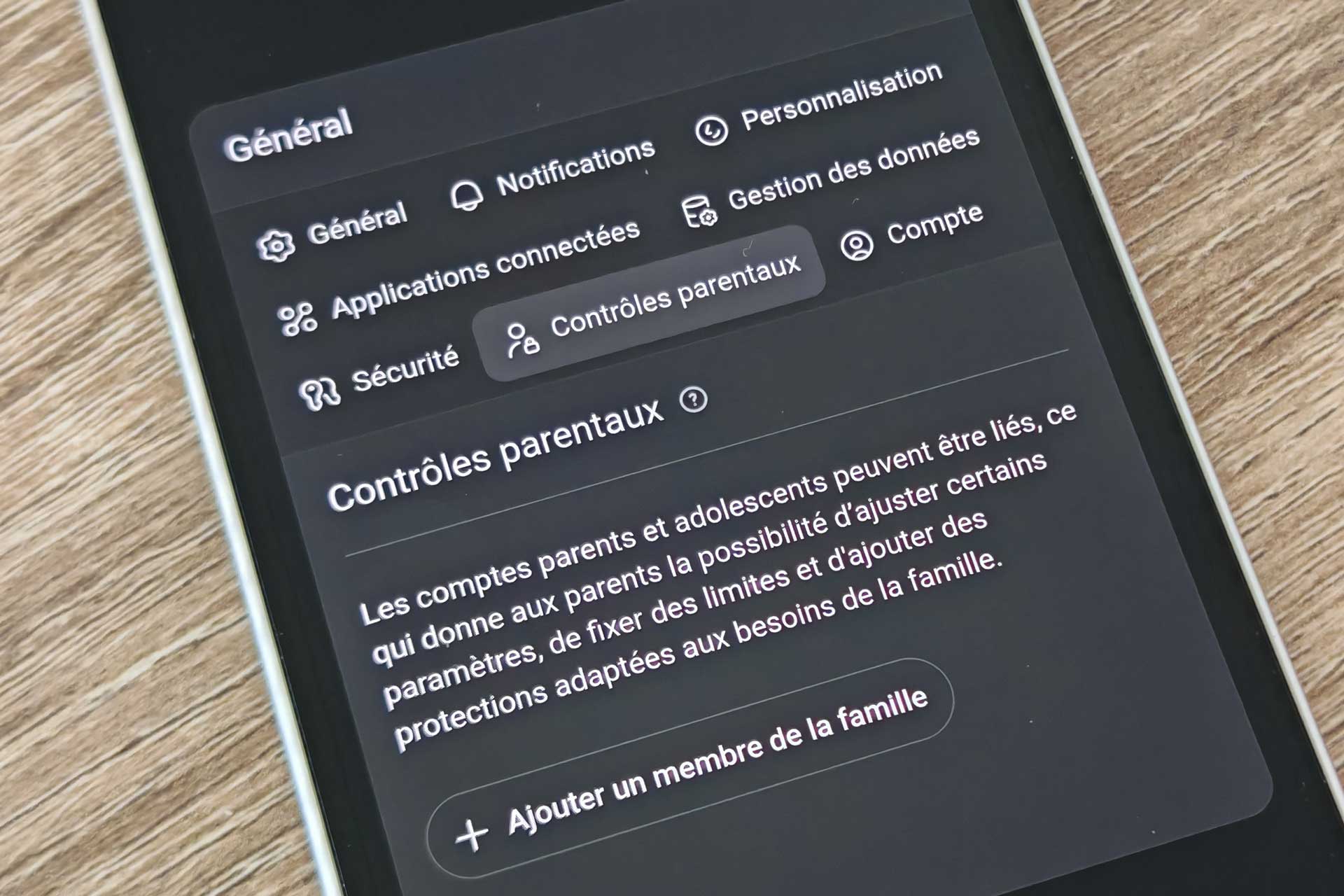

Des garde-fous en réponse à un drame

Le système d’OpenAI permet aux parents de lier leur compte à celui de leur ado pour limiter les contenus sensibles (défis viraux, images violentes…), désactiver la génération d’images, ou encore définir des plages horaires d’utilisation.

Cependant, et c’est un point crucial, les parents n’ont pas accès à l’historique des discussions, sauf si un « risque grave » est détecté par les systèmes d’OpenAI. Une décision qui place l’entreprise dans une position délicate : être à la fois juge et partie de la sécurité de ses jeunes utilisateurs.

[Sondage étudiant] Et vous, comment utilisez-vous l’IA pour vos études ?

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.

Source : Ars Technica