Les modèles IA sous le capot des chatbots ont toujours besoin de données d’entraînement. Claude ne fait pas exception à la règle, et Anthropic veut maintenant collecter les données de ses utilisateurs pour entraîner son intelligence artificielle afin d’en améliorer la sécurité, et pour accélérer la détection de contenus nuisibles.

Jusqu’au 28 septembre pour se décider

« Vous contribuerez aussi à ce que les futurs modèles Claude progressent dans des compétences comme la programmation, l’analyse et le raisonnement, ce qui mènera in fine à de meilleurs modèles pour tous les utilisateurs », ajoute la start-up qui pourra ainsi vendre une IA plus efficace et plus précise grâce aux conversations et au code développé en commun entre Claude et les utilisateurs (ces derniers ne sont pas payés en retour).

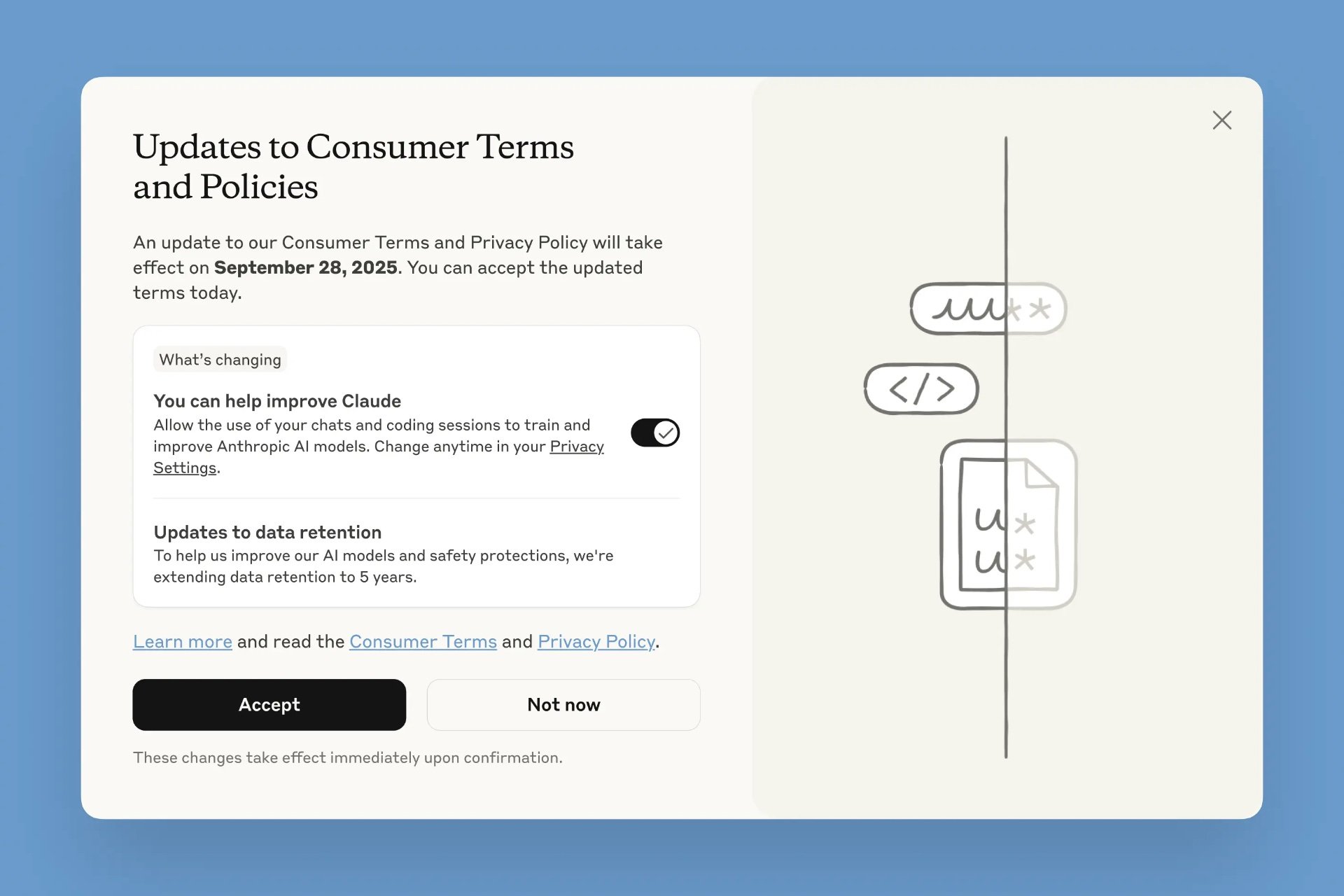

Les abonnés actuels auront jusqu’au 28 septembre pour accepter les nouvelles conditions d’utilisation que le service leur présentera durant une prochaine session. Les utilisateurs Claude Free, Pro et Max sont concernés, y compris ceux qui se servent du mode Code depuis un compte associé aux abonnements. En revanche, les comptes liés aux conditions commerciales (Claude for Work, Gov, Education…) sont exemptés, tout comme l’usage de l’API.

Dès que l’utilisateur accepte la collecte, Claude va commencer à exploiter les nouvelles conversations, mais pas les anciennes discussions — à l’exception de celles qui seront reprises après acceptation. Les nouvelles sessions de code seront elles aussi prises en compte.

Il est possible de refuser la collecte directement dans la fenêtre d’acceptation des conditions d’utilisation, ou depuis les réglages. Si l’utilisateur refuse la collecte après avoir l’acceptée dans les conditions d’utilisation, Claude cessera immédiatement d’exploiter les données ; en revanche, les données précédemment collectées ne pourront pas être supprimées de l’entraînement passé.

Autre changement de taille : la période de conservation des données est prolongée à cinq ans, contre 30 jours actuellement ! Anthropic explique que cette durée très longue améliorera la cohérence des modèles : comme le développement des IA s’étale sur 18 à 24 mois, garder les données plus longtemps permet d’assurer une continuité dans l’entraînement. Et cela renforce la sécurité, puisqu’une conservation plus longue aide à entraîner les systèmes de détection des abus (spam, usages malveillants, etc.) en leur donnant davantage de données sur la durée.

L’utilisateur qui refusera la collecte de ses données reviendra à la période de rétention de 30 jours. L’entreprise rappelle pour finir que les données collectées auprès de ses utilisateurs ne sont pas vendues à des tiers.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.

Source : Anthropic